Виявляється, що без Google не було б революційного чат-бота OpenAI та генераторів зображень Dall-E та Midjourney. Вісім працівників техногіганта, яких захоплювала ідея штучного інтелекту, знайшли одне одного у величезній компанії, щоб розробити ключову для ШІ технологію. Журналіст видання WIRED поговорив із цими вісьмома винахідниками, щоб розповісти їхню історію прориву. Forbes переказує головне з матеріалу.

Купуйте річну передплату на шість журналів Forbes Ukraine за 1259 грн замість 1799 грн. Якщо ви цінуєте якість, глибину та силу реального досвіду, ця передплата саме для вас. В період акції Christmas sale діє знижка 30% 🎁

Вісім імен зазначені авторами «Увага – це все, що вам потрібно» («Attention Is All You Need»), наукової роботи, що побачила світ навесні 2017-го. Всі вони були дослідниками Google, хоча на момент публікації праці один з них вже пішов у самостійне плавання.

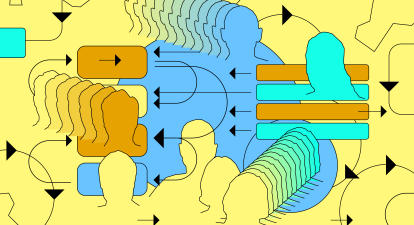

Ця робота стала легендарною. Її автори починали із того, що вдосконалювали набір тогочасних ШІ-технологій під назвою нейромережі, а досягли чогось значно більшого: створили надпотужну цифрову систему, чиї результати здаються ніби не з цього світу. Називається вона «трансформери», і саме завдяки їй у нас сьогодні є чат-боти і генератори зображень.

Не відпустити вперед Siri

Ідейним натхненником і «збирачем» неймовірної вісімки можна назвати Якоба Ушкорайта, сина східнонімецьких іммігрантів. Він народився в Каліфорнії, але його батьки повернулися до Німеччини, де Якоб і закінчив університет. На стажування його взяли у перекладацьку комаду Google.

Відмовившись від ідеї йти у докторантуру, Ушкорайт у 2012-му приєднався до команди Google, яка займалася розробкою системи, що могла відповідати на запитання користувачів на самій сторінці пошуку, щоб їм не треба було переходити на інші сайти.

Коли Apple оголосила про появу голосового асистента Siri, який зможе відповідати на прості запитання, Google відчула загрозу своєму бізнесу і звернула увагу на роботу групи Ушкорайта.

Рекурентні нейронні мережі були передовою ШІ-технологією, і компанія хотіла її використати, щоб система видавала схожі на людські відповіді на запити, пропонувала автозаповнення речень в email-листуванні чи допомагала створювати відносно прості чатботи клієнтської підтримки. Але ця технологія наштовхнулася на обмеження: великі обʼєми тексту.

Рішення цієї проблеми вбачали у «довгій короткостроковій памʼяті» (LSTM), інновації, яка давала змогу мовним моделям опрацьовувати більші і складніші текстові послідовності. Але компʼютер все одно обробляв такі тексти послідовно, тобто слово за словом, і таким чином не враховував контекстні підказки, які могли зʼявлятися в тексті далі.

У 2014-му Ушкорайт почав формулювати інший підхід, який він назвав увагою (attention). Така мережа могла перекладати слова у звʼязці із будь-якими іншими частинами тексту, а отже не послідовно, а комплексно.

Він вважав, що «модель уваги» потенційно може працювати швидше та ефективніше за рекурентні нейронні мережі. Те, як вона обробляє інформацію, чудово пасувало до потужних чипів паралельної обробки, які саме почали масово виробляти для підтримки буму машинного навчання. Ці напівпровідники теж використовували не лінійний принцип обробки, а паралельний. У «моделі» уваги він бачив майбутнє.

Втім далеко не всі розуміли запал Ушкорайта. Йому вдалося переконати кількох колег провести експерименти із «моделлю уваги», які показали багатообіцяючі результати і закінчилися науковою роботою 2016-го.

Але далі цих експериментів із невеличкими шматками тексту його колеги йти не хотіли, а Ушкорайту цього було замало.

Знайти однодумців

Одного дня у 2016-му Ушкорайт обідав у кафе Google із науковцем з України Іллею Полосухіним. Останній на той час працював у компанії вже три роки. Полосухіна поставили на чолі команди, робота якої полягала в наданні відповідей на прямі запитання, які користувачі вписували у пошуковик. Але їхні справи йшли не дуже. Українець розповів WIRED, що їм потрібне було щось дешеве і швидке, і Ушкорайт під час їхнього обіду запропонував йому спробувати «модель уваги».

До їхнього дуету приєднався ще один їхній колега, Ашиш Васвані, який іноді співпрацював із Полосухіним. Васвані народився в Індії, виріс на Середньому Сході, вивчав машинний переклад в Університеті Південної Каліфорнії і приєднався до відносно ново групи з глибокого вивчення штучного інтелекту під керівництвом Google AI — Google Brain.

Утрьох вони створили документ «Трансформери: ітеративна увага і обробка різних завдань». Назву «трансформери», розповів Ушкорайт, вони обрали одразу, адже їхній механізм трансформує інформацію, яку поглинає, дозволяючи системі «зрозуміти» дані. Але, звісно, іграшкові трансформери теж вигулькнули в памʼяті як дитячі спогади: документ закінчувався мальованим зображенням шести трансформерів, які стріляють одне в одного лазерами.

На початку 2017-му Полосухін пішов з Google, щоб заснувати власну компанію, але до їхньої команди однодумців вже почали приєднуватися нові люди. Спершу була індійська інженерка Нікі Пармар, яка вдосконалювала систему пошуку в Google. Потім був валлієць Ліон Джонс, який працював у Google Research під керівництвом Полосухіна.

Робота із трансформерами привернула увагу й інших дослідників Google Brain, які теж намагалися вдосконалити великі мовні моделі. Тож до третьої хвилі «рекрутингу» Ушкорайта належать Лукаш Кайзер, польський науковець-теоретик компʼютерної галузі, і його стажер-канадець Ейден Гомез.

Команда «трансформерів» почала створювати модель уваги, яка б перекладала текст з однієї мови на іншу. Оцінювали результати за допомогою стандарту BLEU, який порівнює роботу машини із роботою людини-перекладача. Від самого початку модель добре себе показала: на рівні із альтернативами LSTM, але не краще за LSTM.

Вийти із фази плато

Після непоганих початкових результатів, група «трансформерів» зайшла у фазу плато, із якої допоміг вийти Ноам Шазір у 2017-му. Ветеран Google, який приєднався до компанії ще у 2000-му і став її легендою, випадково почув про проєкт Ушкорайта. Шазір тоді вже пʼять років займався глибоким навчанням і нещодавно зацікавився великими мовними моделями, які на той час не давали результатів, на які, він був певен, ті здатні.

Йому сподобалася ідея відійти від рекурентних нейронних мереж, тому Шазір із ентузіазмом приєднався до команди розробників-однодумців. Це стало поворотним моментом для усієї групи.

Шазір вирішив написати власну версію коду, який вже мала трансформерна команда. «Я взяв їхню основну ідею і створив код з нуля», – розповів він WIRED.

Решта групи назвала прорив Шазіра «магією» та «алхімією», яка вивела їхню систему на новий рівень.

Дослідники встановили для себе дедлайн – 19 травня. Саме тоді закінчувався термін подання наукових робіт на найбільшу ШІ-подію року – конференцію Neural Information Processing Systems, яка мала відбутися у грудні.

Команда тестувала дві моделі трансформерів: одна, яка створена на основі 12-годинного тренування, і потужніша друга під назвою Big, яка пройшла понад три з половиною дні тренувань. Моделі починали із перекладу тексту з англійської мови на німецьку.

Проста модель перевершила всіх конкурентів, а Big за шкалою BLEU побив усі попередні рекорди, та й у питанні обчислювальної ефективності була на крок попереду інших. «Всі компоненти того, що ми сьогодні називаємо трансформером, стали результатом методу спроб і помилок, який ми застосовували знову і знову із карколомною швидкістю», – сказав Ейден Гомез журналісту WIRED.

За словами дослідників, коли до дедлайну залишалося два тижні, сон мало кого цікавив, і всі «жили» на каві. Вони продовжували збирати результати експериментів до останніх годин кінцевого терміну. «Дані про переклад на французьку прийшли за пʼять хвилин до закриття вікна подання роботи», – пригадує Нікі Пармар.

Цікаво те, що вище керівництво Google сприймало проєкт вісімки як просто ще одну ШІ-ініціативу і, як сказали науковці, навіть не цікавилося тим, як просувається робота. Але оформити патент компанія поспішила одразу.

Відгуки колег на наукову роботу команди були змішаними. «Один був позитивний, інший – дуже позитивний, і ще один був «ок», – розповіла Пармар.

Дослідники приїхали на конференцію, де їм виділили вечірній слот для дискусії, і вони здійняли фурор. Компʼютерний науковець Зепп Хохрайтер, який є співавтором довгої короткострокової памʼяті (LSTM), похвалив їх після того як дослідники понад чотири години виступали на відведеній їм панелі і відповідали на запитання всіх зацікавлених.

Спадщина

«Трансформери» не захопили світ чи навіть Google одразу. Кайзер пригадує, що приблизно в час публікації роботи, Шазір запропонував директорам Google відмовитися від системи індексованого пошуку, яка є основою пошукової системи компанії, і почати тренувати величезну мережу за допомогою трансформерів. Тоді навіть Кайзер вважав цю ідею сміховинною.

А от Ілля Суцкевер, головний дослідник OpenAI, який теж свого часу працював у Google і був знайомий із командою «трансформерів», не проґавив момент. Невдовзі після публікації роботи він запропонував одному із науковців OpenAI взяти до уваги ідею, і це скоро вилилося у перші продукти GPT.

Багато хто закидає Google те, що компанія перестала зосереджуватися на інноваціях і перетворилася на бюрократизовану організацію, яку хвилюють лише прибутки. «Вони не займалися модернізацією. Вони не впроваджували цю технологію», – сказав Гомез Financial Times.

Втім Google все ж почала інтегрувати трансформери у свої продукти у 2018-му – першим був гугл-перекладач. Того ж року компанія презентувала мовну модель на основі трансформерів під назвою BERT, яку почали впроваджувати у пошуковик наступного року. Але такі внутрішні зміни здаються дуже скромними у порівнянні із квантовим стрибком OpenAI і сміливою інтеграцією Microsoft системи на основі трансформерів у свої продукти.

Та й показовим є той факт, що всі вісім авторів революційної наукової роботи пішли з Google. І майже всі, крім Ушкорайта, заснували свої компанії на основі технології трансформерів:

- Near Полосухіна створила блокчейн, чий токен має близько $4 млрд ринкової капіталізації.

- У 2021-му Пармар і Вісвані заснували дві компанії разом: у 2021-му Adept (оцінка $1 млрд) і Essential AI нині ($8 млн інвестицій).

- У Ліона Джонсона є токійська Sakana AI, яку оцінюють у $200 млн.

- Шазір став співзасновником Character AI (приблизна оцінка $5 млрд).

- Гомез заснував у Торонто Cohere, яку оцінюють у близько $2,2 млрд.

- А в Ушкорайта своя біотехнологічна компанія Inceptive вартістю $300 млн.

Лише Кайзер не заснував власну компанію, а приєднався до OpenAI. Там він став одним із винахідників нової технології під назвою Q*, яка, за словами Сема Альтмана, «просуне вперед межі досліджень». Коли журналіст WIRED попросив Кайзера розповісти про Q*, піарник OpenAI мало стілець не перевернув, поспішаючи закрити рота науковцю, щоб той нічого не казав.

Важко заперечувати і той факт, що без Google не було б трансформерів для ШІ. Сама атмосфера компанії заохочувала до співпраці, обміну думками і наукових відкриттів. А зібрання компанією найсвітліших умів світу теж відіграло важливу роль: шість із восьми авторів роботи народилися за межами Штатів, один є сином тимчасових іммігрантів у США, а інший став американцем у першому поколінні.

Ушкорайт зі свого офісу у Берліні сказав, що інновації залежать від правильних умов. Якщо зібрати завзятих ідеями людей в одному місці і дати їм можливість працювати над правильними проблемами, то, за наявності талану, «відбувається магія».

Ви знайшли помилку чи неточність?

Залиште відгук для редакції. Ми врахуємо ваші зауваження якнайшвидше.